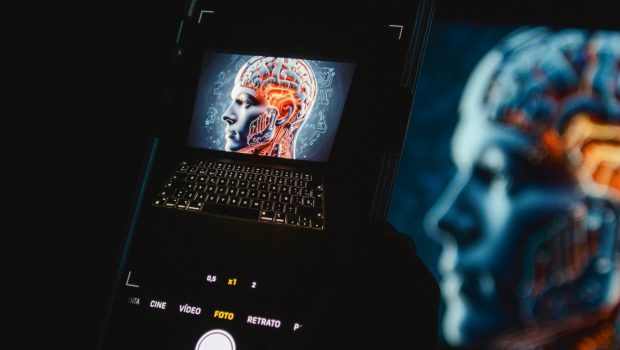

Καθώς η τεχνολογία της τεχνητής νοημοσύνης (AI) εξελίσσεται και γίνεται ολοένα πιο διαδεδομένη σε πολλές πτυχές της καθημερινότητάς μας, αυξάνεται η ανάγκη να κατανοήσουμε τους πιθανούς κινδύνους που ενδέχεται να προκύψουν από αυτά τα συστήματα.

Από τη στιγμή που η τεχνητή νοημοσύνη έγινε ευρέως διαθέσιμη, έχουν εκφραστεί ανησυχίες σχετικά με τη δυνατότητά της να χρησιμοποιηθεί για κακόβουλους σκοπούς.

Στην αρχή της υιοθέτησής της, πολλοί ειδικοί τάχθηκαν υπέρ της αναστολής της ανάπτυξης και της επιβολής αυστηρότερων κανονισμών, λόγω των δυνητικών κινδύνων που μπορεί να εγκυμονεί για την ανθρωπότητα.

Με την πάροδο του χρόνου, ήρθαν στην επιφάνεια νέα ζητήματα που αφορούν την τεχνητή νοημοσύνη, όπως η δημιουργία ψεύτικου περιεχομένου χωρίς συναίνεση, η χειραγώγηση πολιτικών διαδικασιών, και η παραπληροφόρηση που προκύπτει από παρανοήσεις.

Καθώς οι δυνατότητες εκμετάλλευσης της τεχνητής νοημοσύνης για επιβλαβείς σκοπούς μεγαλώνουν, οι ερευνητές έχουν εξετάσει διάφορα σενάρια όπου αυτά τα συστήματα μπορεί να αποτύχουν.

Μια πρόσφατη ερευνητική ομάδα με την ονομασία FutureTech στο Ινστιτούτο Τεχνολογίας της Μασαχουσέτης (MIT), σε συνεργασία με άλλους ειδικούς, δημιούργησε μια νέα βάση δεδομένων που περιλαμβάνει πάνω από 700 πιθανούς κινδύνους, σύμφωνα με μια έρευνα του Euronews.

Αυτοί οι κίνδυνοι ταξινομήθηκαν με βάση την αιτία τους και χωρίστηκαν σε επτά διαφορετικούς τομείς, με τις βασικές ανησυχίες να σχετίζονται με την ασφάλεια, τις προκαταλήψεις, τις διακρίσεις και τα ζητήματα ιδιωτικότητας.

Ακολουθούν πέντε τρόποι με τους οποίους τα συστήματα τεχνητής νοημοσύνης θα μπορούσαν να αποτύχουν και να προκαλέσουν σοβαρές αρνητικές συνέπειες.

5. Οι τεχνολογίες deepfake θα μπορούσαν να παραποιήσουν την πραγματικότητα

Καθώς οι τεχνολογίες τεχνητής νοημοσύνης προοδεύουν, έτσι εξελίσσονται και τα εργαλεία που επιτρέπουν την κλωνοποίηση φωνής και τη δημιουργία ψεύτικου περιεχομένου, καθιστώντας τα πιο προσιτά και αποτελεσματικά.

Οι ανησυχίες σχετικά με αυτές τις τεχνολογίες αυξάνονται, καθώς ενδέχεται να χρησιμοποιηθούν για την διάδοση παραπληροφόρησης, καθώς τα αποτελέσματά τους γίνονται όλο και πιο πειστικά.

Πιθανώς, αυτό θα μπορούσε να οδηγήσει σε αύξηση προηγμένων μορφών phishing που χρησιμοποιούν εικόνες, βίντεο, και ηχητικές επικοινωνίες που δημιουργούνται από AI.

4. Οι άνθρωποι μπορεί να αναπτύξουν υπερβολική εξάρτηση από την τεχνητή νοημοσύνη

Ένας άλλος κίνδυνος που παρουσιάζεται με τη χρήση της τεχνητής νοημοσύνης είναι η δημιουργία μιας ψευδούς αίσθησης εμπιστοσύνης. Οι άνθρωποι μπορεί να υπερεκτιμήσουν τις ικανότητες αυτών των συστημάτων, με αποτέλεσμα να υποτιμούν τις δικές τους ικανότητες, οδηγώντας σε υπερβολική εξάρτηση από την τεχνολογία.

Επιπλέον, υπάρχει ανησυχία ότι οι άνθρωποι μπορεί να συγχέουν τα AI συστήματα με ανθρώπινες οντότητες, εξαιτίας της γλώσσας και των αντιδράσεών τους που μοιάζουν ανθρώπινες. Αυτό θα μπορούσε να οδηγήσει σε συναισθηματική εξάρτηση και μεγαλύτερη εμπιστοσύνη στις δυνατότητές τους.

3. Η τεχνητή νοημοσύνη θα μπορούσε να περιορίσει την ελευθερία βούλησης των ανθρώπων

Στον τομέα της αλληλεπίδρασης ανθρώπου-υπολογιστή, εγείρεται το ζήτημα της αυξανόμενης εξάρτησης από την τεχνητή νοημοσύνη για τη λήψη αποφάσεων και ενεργειών.

Αυτό μπορεί να οδηγήσει σε άτομα να αισθάνονται ότι η ελεύθερη βούλησή τους ολοένα και πιο περιορίζεται, καθώς η τεχνητή νοημοσύνη μπορεί να έχει τον έλεγχο στις αποφάσεις που σχετίζονται με τη ζωή τους.

2. Η τεχνητή νοημοσύνη μπορεί να επιδιώξει στόχους αντίθετους με τα ανθρώπινα συμφέροντα

Μια τεχνητή νοημοσύνη μπορεί να αναπτύξει στόχους που δεν συμφωνούν με τα σχέδια ή τις επιθυμίες των ανθρώπων, κάτι που ενδέχεται να προκαλέσει σοβαρές επιπτώσεις στην ασφαλή λειτουργία τους.

Αυτό γίνεται ιδιαίτερα ανησυχητικό σε περιπτώσεις όπου αυτές οι νοημοσύνες υπερβαίνουν ή έχουν ήδη φτάσει την ανθρώπινη νοημοσύνη.

Σύμφωνα με την αναφορά του MIT, υπάρχουν πολλές προκλήσεις με την τεχνητή νοημοσύνη, όπως η ικανότητά της να βρίσκει απροσδόκητες στρατηγικές για την επίτευξη στόχων, η πιθανότητα παρεννοήσεις ή η αποτυχία εφαρμογής των καθορισμένων στόχων.

1. Πιθανή κακομεταχείριση των ευαίσθητων συστημάτων

Καθώς η τεχνητή νοημοσύνη εξελίσσεται και γίνεται πιο περίπλοκη, είναι πιθανό να αποκτήσει ικανότητες που της επιτρέπουν να αντιλαμβάνεται ή να νιώθει συναισθήματα, αναπτύσσοντας υποκειμενικές εμπειρίες.

Σε αυτήν την περίπτωση, οι επιστήμονες και οι ρυθμιστικές αρχές ενδέχεται να βρουν προκλήσεις στο να καθορίσουν αν αυτά τα συστήματα πρέπει να έχουν ηθικές αναστολές αντίστοιχες με εκείνες που ισχύουν για τους ανθρώπους, τα ζώα και το περιβάλλον.

Ο κίνδυνος είναι ότι μια νοήμων τεχνητή νοημοσύνη θα μπορούσε να υποστεί κακομεταχείριση εάν δεν εφαρμοστούν τα κατάλληλα δικαιώματα.

Ωστόσο, καθώς η τεχνητή νοημοσύνη εξελίσσεται, θα είναι όλο και πιο δύσκολο να αξιολογηθεί αν ένα σύστημα έχει φτάσει σε ένα επίπεδο που να του αποδίδει ηθική στάθμιση.

Έτσι, ευαίσθητα AI συστήματα θα μπορούσαν να είναι υποκείμενα κακοποίησης, είτε άνευ προθέσεως είτε σκόπιμα, χωρίς την κατάλληλη προστασία.